目录

大模型硬件选型指南:从CPU到TPU的实战策略

大模型硬件选型远不止是"买最贵的"这么简单,它更像一场精心策划的烹饪艺术——不同食材需要不同的处理方式,而硬件就像厨房里的各种工具,必须根据任务需求精准匹配。从DeepSeek-R1的1.5B轻量版到671B的"巨无霸",硬件需求天差地别,选择不当可能导致模型加载缓慢、推理延迟高企,甚至根本无法运行。

🔥 硬件选型的三大陷阱与真实痛点

陷阱一:显存越大越好? 这是最常见的误区,许多用户为7B模型购买80GB显存的A100,结果发现性能提升有限,成本却高出10倍。显存确实是关键瓶颈,但盲目追求大显存就像买了一座豪华厨房却只用来煮泡面,资源严重浪费。

陷阱二:忽略CPU与内存协同。GPU虽是主力,但CPU负责数据预处理、任务调度这些"幕后工作"。实测显示,CPU推理耗时2.3秒,而GPU仅需28毫秒,若CPU性能不足,整体效率可能下降50%以上。更令人担忧的是,内存容量不足会导致模型加载缓慢,甚至崩溃。

陷阱三:TPU生态锁。TPU虽在谷歌生态内性能优异,但需依赖TensorFlow框架和谷歌云平台,跨平台兼容性差。非谷歌用户使用TPU需转换框架,可能导致开发周期延长或代码重构成本增加。

这些误区造成的实际后果不容忽视:某用户为DeepSeek-R1的7B版本购买了RTX 4090(24GB显存),结果发现性能提升有限,成本却高出10倍;另一用户仅关注GPU而忽视CPU和内存,导致系统整体性能下降50%以上;还有用户尝试在本地部署TPU,最终因生态不兼容而失败。

💡 大模型硬件架构的三大核心处理器

🎯 CPU:大模型的"指挥官"

CPU就像厨房里的"指挥官",负责统筹整个烹饪过程。虽然它处理单个任务的速度快,但并行能力有限。在大模型训练中,CPU主要负责数据预处理、任务调度和少量推理工作。选择CPU时,需关注核心数、内存带宽和是否支持AVX2/AVX-512指令集——这些直接影响模型加载速度和预处理效率。

以DeepSeek-R1的1.5B版本为例,它可以在现代CPU(如Intel i5或AMD Ryzen 7)上流畅运行,无需独立显卡。这是因为CPU的通用性足以处理小规模模型的推理需求,但若进行训练,则效率会大幅下降。

🔥 GPU:大模型训练的"蜂群"

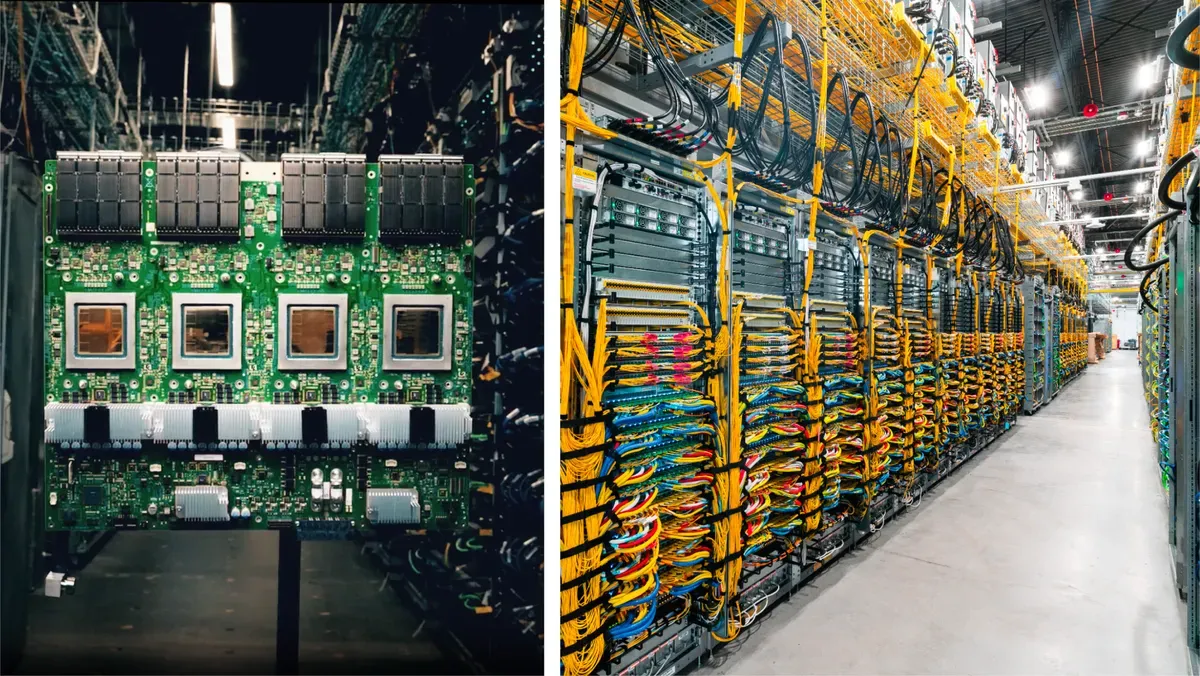

GPU则像厨房里的"蜂群",数千个简化核心协同工作,专注于高吞吐量计算。NVIDIA的GPU在大模型训练领域占据主导地位,因其支持CUDA生态和丰富的AI加速功能。2025年最新的B200 GPU采用Blackwell架构,FP8算力达10 PFlops,支持液冷散热,可将ChatGPT训练能耗从15兆瓦降至4兆瓦。

GPU特别适合处理矩阵运算,这是大模型训练的核心任务。DeepSeek-R1的7B版本需要至少8GB显存的GPU(如RTX 3060),而32B版本则需要多张A100(80GB显存/卡)。GPU的灵活性使其成为科研机构和中小企业的首选,但高功耗和成本也是不容忽视的挑战。

🚀 TPU:谷歌的"定制化工厂"

TPU是谷歌的"秘密武器",专为AI设计的ASIC芯片,就像高度自动化的"定制化工厂"。TPU在矩阵运算上比GPU快180%,但软硬件生态封闭,仅限谷歌云平台使用。TPU v5p的BF16算力达459 TFlops,Int8下918 TOPS,集成HBM3内存,训练GPT-3-175B速度提升180%。

TPU的优势在于极致的能效比和规模扩展能力,但它的缺点也很明显:仅支持TensorFlow框架,无法在本地部署,且需额外支付谷歌云服务费用。除非你是谷歌生态深度用户,否则TPU的使用门槛较高。

就在上个月,这个火的不行,问题好像前几天NVIDIA 反手收购了TPU之父。

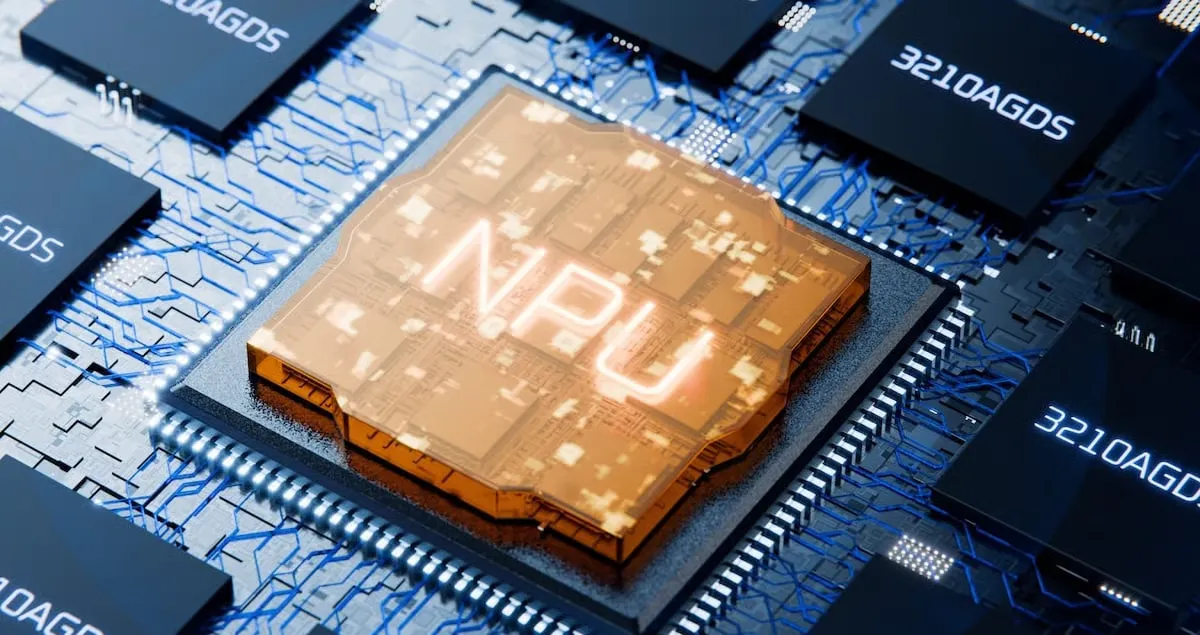

🧠 NPU:设备端的"随身管家"

NPU(神经网络处理器)则是大模型在设备端的"随身管家",专为低功耗场景设计。与GPU的通用性不同,NPU聚焦于特定AI任务,能效比可达GPU的10倍以上。Apple M3芯片集成的16核神经网络引擎,使AI任务性能较M1提升60%,支持DeepSeek-R1的1.5B版本本地部署。

NPU的优势在于功耗低、响应快,适合移动端和边缘设备。但它的局限性也很明显:计算精度较低,无法处理大规模模型训练,仅适合轻量级推理任务。

🌟 DeepSeek-R1各版本硬件配置指南

DeepSeek-R1作为开源大模型,其硬件需求因参数规模而异,形成了从入门到进阶的完整配置谱系:

| 参数规模 | 最低配置 | 推荐配置 | 量化建议 | 适用场景 |

|---|---|---|---|---|

| 1.5B | CPU(4核)+内存8GB+存储5GB | AMD Ryzen 7/A10或Apple M1+内存16GB+存储30GB | 无需量化 | 个人开发者、简单问答、文本生成 |

| 7B | CPU(8核)+内存16GB+显卡4GB | NVIDIA RTX 3060(8GB)或AMD Radeon 7900(16GB)+内存32GB | 8-bit量化 | 代码调试、多轮对话、基础翻译 |

| 32B | CPU(16核)+内存64GB+显卡32GB | NVIDIA A100(80GB×2)或AMD MI300X(128GB)+内存128GB | 4-bit量化 | 企业级应用、专业翻译、内容创作 |

| 70B | CPU(32核)+内存128GB+显卡64GB | NVIDIA H100/A100(80GB×8)或B200(FP8优化)+内存256GB | FP4量化 | 科研机构、大规模数据分析、复杂推理 |

| 671B | CPU(64核)+内存512GB+显卡集群 | NVIDIA DGX B200(8×B200)或AMD Instinct MI350×16+内存1TB | 混合精度量化 | 国家级实验室、AGI研究、超大规模计算 |

DeepSeek-R1的硬件需求遵循"参数量每扩大10倍,显存需求暴涨4倍"的规律。例如,7B模型需8GB显存,而70B模型则需64GB显存。但通过量化技术,这一需求可大幅降低——4-bit量化能将显存占用减少75%,使32B模型在16GB显存的GPU上运行成为可能。

值得注意的是,DeepSeek-R1的671B版本虽然参数量庞大,但由于采用了混合专家(MoE)架构,实际激活参数只有37B,因此显存需求并非简单的线性增长。这一特性使得DeepSeek-R1在推理阶段的硬件需求远低于同等参数的其他模型,为大规模部署提供了便利。

🛠️ 硬件优化的五大实用技巧

🎯 量化技术:让大模型"轻装上阵"

量化是降低硬件需求的核心技术,4-bit量化能将DeepSeek-R1的70B模型显存需求从64GB降至32GB,同时保持95%以上的推理精度。具体实现方法如下:

NVIDIA GPU量化:使用TensorRT-LLM框架,支持FP4/INT8混合精度量化。通过设置--precision=FP8参数,可将模型推理速度提升25倍,每token成本降低20倍。

AMD GPU量化:使用ROCm平台,需手动设置HIP_VISIBLE_DEVICES环境变量并升级bitsandbytes至0.43.3版本。

🔥 混合精度训练:平衡速度与精度

混合精度训练结合了FP16和BF16的优势,在保持精度的同时显著提升训练速度。DeepSeek-R1采用FP16+FP8混合精度训练,显存占用降低40%,训练速度提升30%。

🚀 激活检查点:减少显存占用的"内存魔术"

激活检查点(Activation Checkpointing)是一种"内存魔术",通过选择性保存中间激活值,使训练内存效率提升3倍。对于DeepSeek-R1的70B模型,激活检查点可减少30%的显存占用。

🧠 梯度累积:模拟大batch训练的"巧手"

梯度累积是一种模拟大batch训练的"巧手",通过多次小batch计算累积梯度再更新权重,可显著提高训练吞吐量。对于DeepSeek-R1的32B模型,梯度累积可使batch size从2K扩展至16K。

🌟 统一内存设计:打破CPU与GPU界限

统一内存设计是2025年的硬件革命,Apple M3 Ultra通过"内存池"技术将CPU和GPU内存统一管理,使DeepSeek-R1的671B模型在512GB内存的Mac Studio上流畅运行;AMD Ryzen AI的高带宽内存(HBM)也支持类似功能。

对于Windows系统,可通过以下命令启用大页内存:

bashnvidia-smi -i 0 --set-persistence=1

对于macOS系统,Apple M3 Ultra的统一内存池技术会自动管理内存分配,无需额外配置。

📈 多卡并行策略:从单卡到集群的"团队协作"

大模型训练需要强大的并行计算能力,多卡并行就像组建一个高效的烹饪团队,各司其职又紧密协作。DeepSeek-R1支持多种并行策略:

数据并行(DDP):适合单机多卡,简单高效。对于7B模型,4卡RTX 4090通过DDP可实现接近4倍的加速。

模型并行(MP):适合超大规模模型,如671B版本的DeepSeek-R1。通过将模型的不同层分配到不同GPU上,可突破单卡显存限制。

张量并行:结合数据并行和模型并行,适合中等规模模型(如14B-32B)。DeepSpeed的ZeRO-3优化器可将显存需求降低70%。

对于集群级部署,NVIDIA的NVLink 5.0带宽达1.8TB/s,AMD的Infinity Fabric技术也提供了类似的高速互联能力。这些技术使DeepSeek-R1的70B版本可在8+张A100/H100上高效训练。

📊 案例分析:不同场景下的硬件选择策略

🎯 个人开发者:小而美的轻量级方案

个人开发者应优先考虑性价比,而非盲目追求高端硬件。对于DeepSeek-R1的1.5B版本,可选择AMD Ryzen 7或Intel i7处理器,搭配16GB内存和8GB显存的GPU(如RTX 3060)。这一配置既能满足基本推理需求,又能兼顾日常开发工作。

bash# 在个人电脑上部署DeepSeek-R1-1.5b

ollama run deepseek-r1:1.5b

🔥 中小企业:平衡性能与成本的"黄金分割"

中小企业应寻找性能与成本的"黄金分割点",优先考虑支持量化技术的中端GPU。对于DeepSeek-R1的7B版本,可选择RTX 4070 Ti(12GB显存)或AMD Radeon RX 7900 XTX(24GB显存),搭配32GB内存和NVMe SSD。这一配置可支持客服系统、内容生成等企业级应用。

bash# 在中小企业服务器上部署DeepSeek-R1-7b

docker run --gpus all -v /data:/data deepseek-r1-7b:latest

🚀 大型企业:构建高效AI基础设施

大型企业应构建专业的AI基础设施,支持大规模分布式训练。对于DeepSeek-R1的32B-70B版本,可采用NVIDIA DGX A100(4×A100)或AMD EPYC 9004系列(64核)服务器,搭配128GB内存和8TB NVMe SSD。这一配置可支持金融分析、医疗诊断等高精度专业任务。

bash# 在企业级服务器上部署DeepSeek-R1-70b

horovodrun -np 8 -H localhost:8 python train.py --model deepseek-r1-70b

💡 未来趋势:AI硬件的三大发展方向

AI硬件正在经历前所未有的变革,未来三年将呈现三大趋势:

1. 专用芯片的崛起:NPU和TPU等专用芯片将逐渐普及,2025年AI笔记本电脑的渗透率有望达到50%,使大模型在终端设备上运行成为可能。

2. 统一内存架构的普及:Apple M3 Ultra和AMD Ryzen AI的统一内存设计将改变硬件选型规则,使大模型在消费级设备上运行成为可能,降低AI门槛。

3. 液冷技术的广泛应用:随着GPU功耗不断攀升(如B200的TDP达500W-700W),液冷技术将成为高性能计算的标配,解决散热与能效问题。

🌟 互动环节:分享你的硬件优化经验

你是否在DeepSeek-R1的硬件选型与优化中遇到过挑战? 请在评论区分享你的经验与解决方案:

- 你用DeepSeek-R1跑70B模型时,是选了NVIDIA B200的FP4量化,还是AMD的PTX底层优化?哪种方案更符合你的需求?

- 本地部署大模型时,你遇到过哪些硬件瓶颈?如何通过量化或内存管理解决?

- 你认为统一内存设计(如Apple M3 Ultra)能否真正降低大模型的硬件门槛?为什么?

你的经验对其他开发者可能至关重要,期待看到你的分享! 如果你对硬件优化有疑问,也可以在评论区提出,我会尽力解答。

✨ 金句

- "显存是关键瓶颈,内存是保障,CPU是后盾,三者缺一不可"——硬件选型需要全面考虑,而非只关注GPU。

- "量化技术是大模型的'轻装上阵',FP4量化让70B模型速度狂飙25倍"——量化技术正在重塑AI硬件需求。

- "统一内存设计是打破CPU与GPU界限的'革命',使671B模型在消费级设备上运行成为可能"——硬件架构创新正在降低AI门槛。

觉得有用?赶紧转发给更多同行,让更多人避开硬件坑!硬件选对了,大模型才能"跑得飞起",选错了,只能"干瞪眼"。 显存是关键瓶颈,内存是保障,CPU是后盾,三者缺一不可。

📌 结尾

大模型硬件选型的核心在于"精准匹配",而非盲目追求高端配置。通过本文的分析,我们可以总结出三个关键点:

- 不同处理器各有所长:CPU是指挥官,GPU是蜂群,TPU是定制化工厂,NPU是随身管家,根据任务需求选择合适的处理器组合。

- 量化技术是降低硬件门槛的"利器":4-bit量化可将显存需求降低75%,FP4量化甚至可使70B模型在中端GPU上运行。

- 统一内存设计是未来趋势:Apple M3 Ultra和AMD Ryzen AI的统一内存池技术正在改变硬件选型规则,使大模型在消费级设备上运行成为可能。

硬件选型不是一成不变的,它需要根据模型需求、任务特性和预算限制不断调整。希望本文能帮助你避开硬件陷阱,找到最适合的配置方案。

本文作者:技术老小子

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!