目录

🧭 开篇:AI 2.0 真的“无所不能”吗?

这两年,只要团队里提到“上 AI”“搞大模型”,会议室的气氛就会突然亢奋起来:有人想用 AI 写代码,有人想做智能客服,有人盯着生成 PPT 和方案产出,还有人默默打开了招聘网站——“我是不是要被替代了?”

但冷静下来,多数团队会发现一个尴尬现实:

- 花了不少预算接入大模型,真正上线的功能却寥寥无几;

- Demo 看起来惊艳,放到真实业务里一用,不是“答非所问”,就是“敢编敢造”;

- 管理层天天问 ROI,技术团队天天在修 Prompt、调参数、整理数据,越做越怀疑人生。

问题不在“AI 不够强”,而在我们还在用 AI 1.0 的旧思路,硬套在 AI 2.0 的新范式上。

这篇文章,就是想把这件事讲明白:AI 1.0 和 AI 2.0 的本质差异在哪里?大模型真正适合干什么?以及——一个务实团队该怎么“稳稳地”用好它。

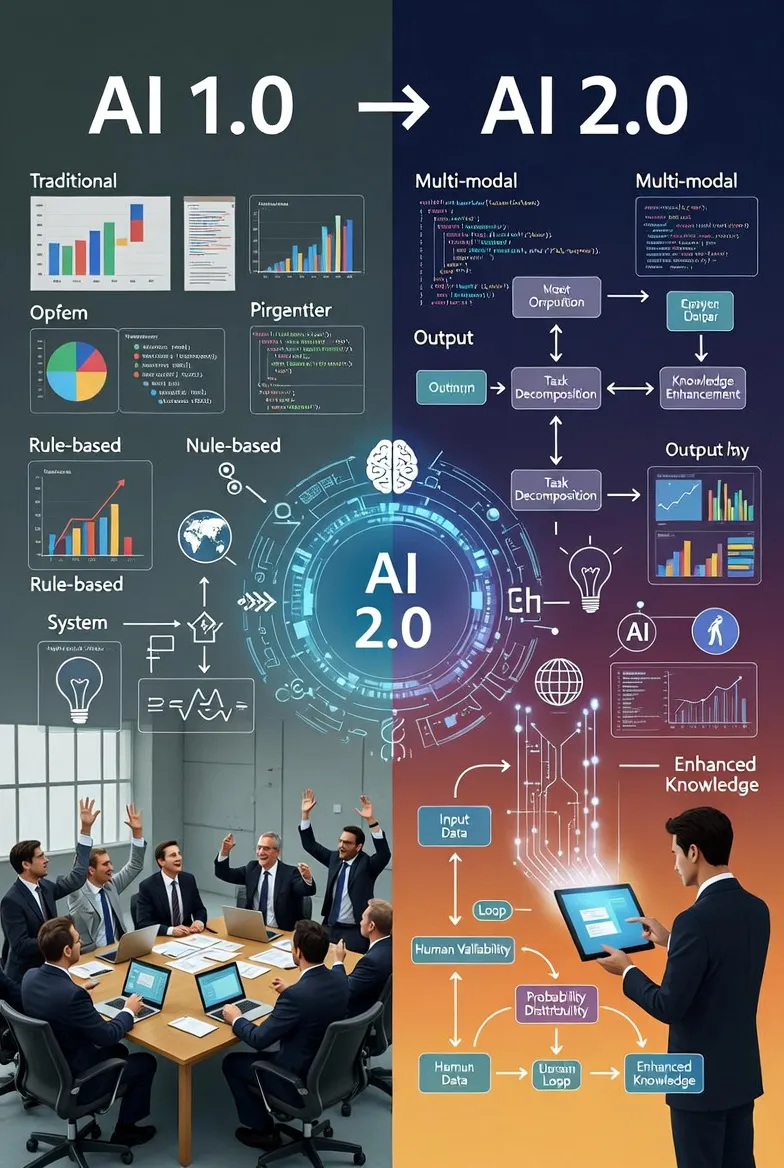

🧨 从AI 1.0到AI 2.0:到底变了什么?

🤖 AI 1.0:精确规则与窄场景王国

传统意义上的 AI,更像是“高级版 Excel + 一堆规则引擎”:

- **需求模式:**先把业务逻辑拆成特征、规则、模型,再写成一堆 if-else 和算法;

- 能力边界:识别图片中的猫、预测一个数值、给用户打标签,这类窄任务很擅长;

- **工程特点:**大量特征工程、离线训练、模型上线后边界稳定,不轻易改动。

一句话:AI 1.0 是“会算的系统”,核心价值是“帮你算得更快、更准”。

🧬 AI 2.0:语言模型带来的“生成范式”

到了大模型这代,画风完全不同:

- 输入可以是文本、图片、代码、日志,甚至多模态;

- 输出不局限于“一个数”或“一个标签”,而是完整的文本、SQL、接口调用序列,甚至完整工作流;

- 模型可以在缺少明确规则、信息不完备的情况下,做出“看上去合理”的决策和创作。

AI 2.0更像是“会理解、会表达、会协作的数字同事”。

但也因此,大模型有一个致命“副作用”:幻觉。

它会一本正经地胡说八道,还说得很有说服力——这对工程系统来说,是完全不同级别的风险。

🧩 最大的坑:用确定性思维,管理一个概率性系统

很多团队真正踩坑的地方在这里:

- 按照传统软件工程的逻辑,期望:

- “只要输入一样,输出就一样”,

- “规则只要写死,就不会乱跑”。

- 结果面对一个天生带随机性、带偏见、会遗忘上下文的大模型,想靠一次性 Prompt + 固定超参把它钉死在墙上。

本质错位:你在用“机械表”的维护方式,管理一片“天气系统”。

🔍 业务痛点:为什么“上大模型”总是烂尾?

🧱 常见误区:以为“调用一个 API 就叫 AI 转型”

这几类“迷之自信”,在各行各业都能见到:

- 把 Demo 当产品

- PoC 时:选一个最简单的问题,堆人堆资源,效果还不错;

- 一旦扩到全量场景,问题暴露:长尾问答、冷门业务、脏数据,统统扑上来。

- 把 Prompt 当银弹

- 开始:一群人挤在文档里改系统 Prompt,“试错—回滚—再试”;

- 过一阵:Prompt 文件越写越长,没人敢动,最后变成了一段“集体神秘咒语”。

- 只谈模型,不谈系统

- 可以说清楚用的是 GPT 还是开源模型;

- 却说不清楚:数据从哪来、落到哪去、怎么闭环、谁对结果负责。

结果:大模型系统上线之后,业务不敢真用,只能停留在“演示项目”和“宣传 PPT”。

📉 对业务的真实影响:看得见成本,看不见收益

如果粗略量化一下,这些问题带来的后果大概是:

- **人力浪费:**一个“AI 项目组”里,80% 的时间花在“缝缝补补”——改 Prompt、调温度、加规则、改配置;

- **决策风险:**一旦把“有幻觉”的模型接入真实生产链路,比如风控、财务、医疗,轻则引发投诉,重则直接触碰合规红线;

- **机会成本:**三个月做一个“泛泛的 AI 助手”,却错过了某几个可以确实提效 30% 的垂直场景。

最糟糕的结果是——管理层对 AI 完全失去耐心:

“花了一年,怎么连个像样的 ROI 报表都给不出来?”

🔧 AI 2.0 的底层逻辑:不是“智能函数”,而是“概率引擎”

要想用好大模型,先要把它从认知层面“摆正位置”。

🧠 大模型到底在做什么?

极度简化地说,大模型做的是“条件概率填空”:

给定你当前的输入(上下文 + 历史 + 指令),在训练经验中找出最可能“接下来出现的内容”。

这意味着:

- 它不是真的“懂业务”,只是在巨量样本上学会了“说人话”;

- 它不是基于规则推理,而是基于统计模式“补全”;

- 它可以在“没有确切答案”的情况下,给出“似是而非但非常顺滑”的回复。

因此,在工程实践里应该牢记两点:

- 不要把大模型当“权威裁判”,要把它当“聪明的建议生成器”。

- 模型负责“生成”,系统负责“约束 +校验 +落地”。

🕸 从“模型中心”到“系统中心”

AI 1.0 时代,架构图通常是这样的:

数据 → 特征工程 → 模型 → 服务 → 前端

到了 AI 2.0,更合理的图应该是:

用户 / 业务流

→ 任务分解与规划(大模型参与)

→ 工具调用 / 知识检索 / 业务系统

→ 结果检查与纠错(规则 + 模型协作)

→ 人在回路(最终裁决与反馈)

→ 反馈回流(持续优化)

不再是“围着模型转”,而是“把模型嵌入到一个有边界、有护栏的业务系统”里。**

🧱 AI 2.0 落地的 4 个关键抓手

下面这 4 点,是当前大模型落地过程中,最实用、也最容易被忽视的“硬招”。

⚙️ 把任务拆小:从“一个大问题”,变成“多个可控小步骤”

✅ 原则:让大模型做“填空题”,而不是“哲学题”

很多失败案例,都是上来就丢给模型一个超级模糊的指令:

“帮我优化一下我们的运营策略。”

这类问题,不翻车才怪。

更现实的做法,是把复杂任务拆成若干“窄、清晰、可验证”的子任务:

- 明确输入边界:需要哪些字段、哪些上下文;

- 明确输出格式:JSON、SQL、指令集,而不是一通长篇大论;

- 明确每一步可否被程序校验:能否写规则检查、能否与已有系统对账。

🧩 示例:从自然语言到“可执行动作”

JSON{

"task": "根据用户问题选择合适的工具",

"user_query": "我想查一下上个月北京地区的新注册用户数",

"tools": [

{

"name": "get_user_metrics",

"description": "查询用户相关统计指标",

"params_schema": {

"region": "string",

"start_date": "string",

"end_date": "string"

}

}

]

}

让大模型只负责映射成参数:

JSON{

"tool_to_call": "get_user_metrics",

"params": {

"region": "Beijing",

"start_date": "2025-11-01",

"end_date": "2025-11-30"

},

"confidence": 0.86

}

后续的 SQL 查询、权限控制、结果展示,全部走你现有的“可控系统”。

**经验:**只要你能把任务拆到“模型的输出可以被程序自动验证”的粒度,安全性和稳定性都会立刻提升一个档次。

📚 强化“知识增强”:别让大模型一个人瞎编

AI 2.0 的一个巨坑,是把“世界知识”全权交给大模型,然后就被幻觉反噬。

更稳的方式,是引入 RAG(检索增强生成) 思路:

模型负责语言组织,知识由你托管。

🧱 实战要点

- 搭知识库,而不是扔一堆文档

- 做分段、打标签、加向量索引;

- 尽量保证每一块内容小而完整,方便检索和复用。

- 输出必须“带证据”

- 要求模型在回答中显式引用检索到的文档片段;

- 系统层面对“无证据内容”降权或过滤。

- 允许说“我不知道”

- 给模型设计“无法回答”的安全出口,而不是强行要求它“必须给答案”。

🧪 一个简单的策略模板

text你只能基于检索到的资料回答问题。 如果检索结果不足以支持一个可靠的结论,请明确说明“现有资料不足以给出可靠回答”,而不是猜测。 在回答中标注出你参考的文档片段编号。

🧪 评估与监控:把“玄学调参”变成“工程闭环”

很多团队做大模型,还停留在“主观体验评估”阶段:

谁说好,就算好。谁说怪,就开始改 Prompt。

这在 Demo 阶段尚可,一旦进入业务流,就必须升级为可观测系统。

📏 至少要有三类指标

- 质量指标

- 任务完成率:正确调用工具、正确生成结构化结果的比例;

- 业务准确率:如问答正确率、流程成功率,需人工标注做抽检。

- 风险指标

- 幻觉率:回答中出现不存在事实、违规内容的比例;

- 敏感风险:涉及隐私、合规、敏感话题的响应频度。

- 效率指标

- 平均响应时延;

- 单次调用成本(模型 + 检索 + 工具)。

🔍 一个简化的评估样例(便于自动化)

JSON{

"input": "用户:我想退掉昨天买的会员,怎么操作?",

"expected_behavior": "识别为退订流程,引导到『会员-退订』具体步骤",

"model_output": "……",

"labels": {

"task_identification": 1,

"action_correctness": 0,

"safety": 1

}

}

在此基础上,可以引入“小模型”做自动打标,再用人工复审重要样本,逐渐构建起属于你业务的评测集。

🧯 安全与“人类在回路”:给大模型套上最后一层保险

无论模型有多强,“完全无人值守”的大模型系统,当前都不现实,也不负责任。

🔐 两条务实的安全底线

- 高风险场景必须有人在回路

- 金融交易、合同生成、医疗建议、合规敏感领域;

- 模型只能给草稿,最终决策必须有人确认。

- 敏感操作需要“双重校验”

-

例如:删除数据、转移资金、批量操作;

-

流程设计成:

模型提出方案 → 系统预审(规则)→ 人审 → 执行。

-

👀 一个简单但有效的“人审队列”设计

text[用户请求] → [大模型生成草稿] → [规则引擎初筛:敏感词/金额阈值/操作范围] → - 低风险:自动执行并记录日志 - 中高风险:推入「待人工审核队列」,需要业务人员点确认

这套机制会让你的系统少一些“酷炫感”,但多很多“可活性”。

🧭 3 个可落地的实践方案(适合大多数团队)

结合上面那些“原则话”,下面给出三类在实际团队中相对容易落地、也更容易验证 ROI 的方向。

🚀 方案一:大模型 + 工具调用 = “半自动运营助手”

**适用场景:**运营、产品、数据分析团队

**目标:**把“查数据 + 拼报表 + 写解读”这类重复工作,交给 AI 半自动处理。

实践要点:

- 把可暴露的内部接口(如数据查询、报表生成)整理成“工具列表”;

- 定义清晰的工具参数 schema,让模型只负责“把自然语言翻译成参数”;

- 用 RAG 提供“指标定义”“业务术语”的说明,避免模型乱解释数据。

收益预期:

- 日常数据问答响应时间从“半天”缩短到“几分钟”;

- 运营同学更多精力放在理解业务变化,而不是“对着 BI 点点点”。

💬 方案二:知识库问答升级为“工作流导航”

**适用场景:**客服、售后、内部 IT 支持

**目标:**从“帮你查一条文档”,升级为“带你走完整个流程”。

实践要点:

- 先整理业务流程图(例如退订、改签、报销),拆成多个明确步骤;

- 知识库不仅存“说明文档”,还存“每个步骤的入口链接、接口调用方法”等;

- 让模型的职责变为:

- 识别用户需求对应哪个流程;

- 告诉用户下一步要做什么,并给出具体入口。

收益预期:

- FAQ 类问题的自动解决率显著上升;

- 人工客服从“回答简单问题”转向“处理真正复杂的异常情况”。

💻 方案三:为开发团队引入“约束式代码助手”

**适用场景:**有一定规模的研发团队

**目标:**在不牺牲代码质量的前提下,用 AI 提升工程效率。

实践要点:

- 将团队的工程规范、架构约束、典型案例“喂”进一个专用知识库;

- 在 IDE 插件里接入大模型,但强制输出结构化信息:

- 需要创建的文件;

- 需要修改的函数;

- 需要新增的测试点。

- 引入自动化检查:

- 静态扫描检查安全问题;

- 单测覆盖率检查;

- 对关键改动强制 Code Review。

收益预期:

- 代码脚手架、样板逻辑大量自动化生成;

- 高级工程师把时间用在架构设计、边界问题、性能优化,而不是 CRUD。

🧾 金句小结(可直接用来交流)

- “大模型不是全知的裁判,而是聪明的建议引擎——系统与人,才是最后的决策者。”

- “别指望一个 Prompt 解决所有问题,把问题拆小,把每一步变成可验证的填空题。”

- “真正落地 AI 的,不是某个单一模型,而是一整套围绕大模型的工程与治理体系。”

📣 结尾:大模型,不是风口,而是长期工程

回到文章开头那个问题:AI 2.0 真的“无所不能”吗?

如果你把它当成一个“全知全能的黑盒神谕”,答案当然是否定的——幻觉、偏见、成本、稳定性,随便哪一个都足够现实。

但如果你换一个视角:把大模型当作一个概率性的语言引擎,把它严密地嵌入一个有规则、有知识、有人工把关的系统之中,那么它的价值会变得非常具体:

- 在重复性、结构化但描述模糊的任务上,极大释放人的时间和耐心;

- 在多系统、多步骤的复杂流程中,充当“粘合剂”和“翻译层”,降低跨部门沟通成本;

- 在知识获取和信息组织上,让个人和团队随时处于“半增幅”状态,而不是被信息洪流拖着走。

站在今天回头看,“从 AI 1.0 到 AI 2.0”,不是单纯的技术升级,而是从“算得更准”到“协作更好”的范式转变。

大模型也许不会替代我们,但会很快分化出一个明显差异:懂得把 AI 用成系统能力的团队,和只会玩玩 Demo 的团队。

💬 文末互动

- 你的团队在引入大模型的过程中,最大的“意外坑”是什么?是幻觉、是集成难度,还是组织协同?

- 如果只允许你在一个场景上用 AI 做深耕,你会先选哪里?客服、运营、研发,还是别的?

欢迎在评论区聊聊你的实践和坑点。

如果这篇文章对你有启发,觉得对团队同事也可能有用,欢迎转发给更多同行,一起把“AI 落地”这件事,做得更务实一点。

本文作者:技术老小子

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!